NVIDIA가 자율주행 기술의 판도를 뒤흔들 강력한 한 수를 던졌습니다. 2026년 1월 5일, NVIDIA는 단순한 인지 모델을 넘어 자율주행 차량에 ‘사고’하고 ‘설명’하는 능력을 부여하는 개방형 생태계, **알파마요(Alpamayo)**를 전격 공개했습니다. 젠슨 황(Jensen Huang) CEO는 이를 두고 “피지컬 AI(Physical AI)의 ‘ChatGPT 모먼트’가 시작됐다"고 선언하며, 자동차가 생전 처음 마주하는 돌발 상황에서도 스스로 판단하고 논리적으로 대응할 수 있는 시대가 왔음을 알렸습니다.

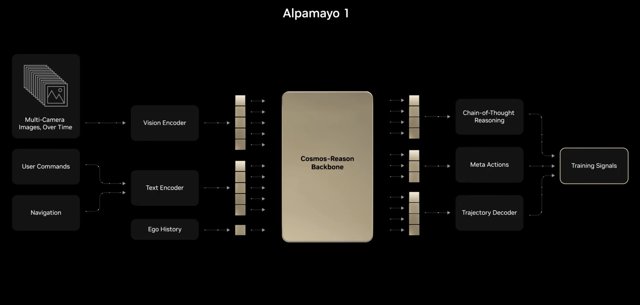

이번 프로젝트의 첫 결과물인 **알파마요 1(Alpamayo 1)**은 이른바 ‘시각-언어-행동 모델(VLAM, Vision-Language-Action Model)‘로 불리는 괴물 같은 성능을 자랑합니다. 쉽게 풀이하자면, 자동차가 눈으로 본 정보(시각)를 언어적 맥락으로 이해하고, 이를 바탕으로 실제 운전 동작(행동)을 결정하는 구조입니다. 덕분에 알파마요는 “왜 갑자기 쇼핑 카트를 피해 운전대를 꺾었나?“라는 질문에 대해 명확한 ‘추론 과정’을 제시할 수 있습니다. NVIDIA는 이 인공지능을 학습시키기 위해 전 세계 2,500개 이상의 도시에서 수집한 30만 개 이상의 실제 주행 영상이 담긴 **피지컬 AI 데이터셋(Physical AI dataset)**도 함께 공개했습니다.

이것이 왜 중요한가?

그동안 자율주행 업계는 기술에 대한 대중의 불신이라는 높은 벽에 가로막혀 있었습니다. 사고의 과정을 알 수 없는 ‘블랙박스’ 같은 인공지능은 신뢰를 얻기 어려웠기 때문입니다. NVIDIA는 의사결정 과정을 논리적으로 설명할 수 있는 ‘설명 가능한 AI(XAI)‘를 전면에 내세우며 이 신뢰의 문제를 정면 돌파하겠다는 전략입니다.

이러한 ‘추론 중심 모델’로의 전환은 자율주행의 성배로 여겨지는 레벨 4(Level 4), 즉 운전자의 개입 없이 대부분의 상황을 스스로 해결하는 완전 자율주행으로 가기 위한 필수 관문입니다. 이제 자율주행은 단순히 도로를 ‘보는’ 단계를 지나, 도로 위에서 벌어지는 상황을 진짜로 ‘이해하는’ 단계로 진화하고 있습니다.