로봇 공학계에 한 획을 긋는 중대한 움직임으로, **베이징 휴머노이드 로봇 혁신 센터(X-Humanoid)**가 XR-1 모델을 공식적으로 오픈 소스화했습니다. 이것은 단순히 GitHub에 툭 던져진 또 하나의 알고리즘이 아닙니다. XR-1은 중국 국가 단위의 ‘신체화된 AI 표준’을 통과한 최초의 VLA(Vision-Language-Action) 모델입니다. 이 표준은 로봇을 단순히 실험실의 호기심 덩어리에서 벗어나 실제 작동하는 기계로 탈바꿈시키기 위해 고안된 벤치마크이죠. 이번 공개에는 XR-1 모델, 포괄적인 RoboMIND 2.0 데이터셋, 그리고 시뮬레이션을 위한 고정밀 디지털 자산 라이브러리인 ArtVIP가 포함되어 있습니다.

본질적으로 XR-1은 대부분의 로봇을 여전히 어설프고 갈팡질팡하게 만드는 ‘인지-행동 장벽’을 부수기 위해 설계되었습니다. 개발자들이 ‘통합 시각-동작 코드(UVMC)‘라고 부르는 기술을 사용하는데, 이는 로봇이 보는 것과 움직여야 할 방식 사이에 공통된 언어를 만듭니다. 덕분에 누군가 컵을 움직이면 따르던 동작을 멈추는 것과 같은 ‘본능적인’ 반응이 가능해지죠. 3단계 훈련 과정을 거쳐, 이 모델은 양팔 로봇인 Franka 시스템부터 X-Humanoid 자체의 Tien Kung 휴머노이드 시리즈에 이르기까지, 완전히 다른 로봇 본체에 걸쳐 그 기술을 일반화할 수 있습니다.

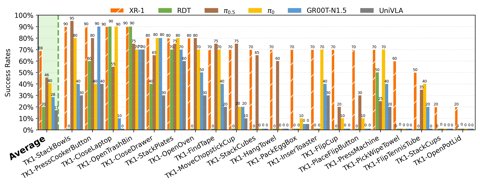

이것은 단순히 이론적인 기량 자랑이 아닙니다. X-Humanoid는 XR-1이 5가지 다른 종류의 문을 자율적으로 통과하고, 정밀한 산업 분류 작업을 수행하며, 심지어 Cummins 공장에서 무거운 물건을 들어 올리는 작업까지 해내는 것을 시연했습니다. 이러한 성과를 뒷받침하는 것은 이제 300,000개 이상의 작업 궤적을 포함하는 RoboMIND 2.0 데이터셋과 ArtVIP 디지털 트윈 자산입니다. 팀은 이 시뮬레이션 데이터를 훈련에 통합하면 실제 작업 성공률을 25% 이상 높일 수 있다고 주장합니다.

왜 이것이 중요할까요?

단순히 모델만이 아니라 데이터와 시뮬레이션 자산으로 이루어진 전체 생태계를 오픈 소스화함으로써, X-Humanoid는 실용적이고 자율적인 로봇 개발을 표준화하려는 계산된 전략을 펼치고 있습니다. 국가적으로 인증된 최초의 신체화된 AI 모델을 무료로 공개하는 것은, 일종의 기초 플랫폼을 구축하려는 직접적인 시도입니다. 이는 잠재적으로 진입 장벽을 낮추고 전체 분야를 가속화할 수 있습니다. 고립된 학술 프로젝트를 넘어, 마침내 실제로 ‘일을 해낼 수 있는’ 로봇을 만들기 위한 공통 기반을 마련하려는 전략적 노력을 시사하는 것이죠.