로봇 산업에는 불편한 진실이 하나 있습니다. 로봇에게 유용한 작업을 가르치는 일은 고통스러울 정도로 느리고, 상상을 초월할 만큼 비싸다는 것입니다. 수년 간 업계의 정설은 시각-언어-행동 모델(VLA)로 지능을 무작정 밀어붙이는 방식이었습니다. 이는 인간이 수만 시간 동안 로봇을 일일이 꼭두각시처럼 조종하며 상상 가능한 모든 작업을 훈련시켜야만 하는, 그야말로 어마어마한 규모의 데이터 병목 현상을 초래했습니다.

이제 로봇 공학 기업 1X는 이단에 가까운 해결책을 제시하고 나섰습니다. 그들의 NEO 휴머노이드 로봇을 위한 새로운 접근법은 겉보기에는 단순하지만 놀랍습니다. 고된 훈련을 중단하고, 로봇이 ‘인터넷’이라는 방대하고 혼돈스러우며 끝없이 교훈적인 인간 행동의 도서관을 그저 ‘관찰’함으로써 학습하게 하자는 것입니다. 이는 단순한 업그레이드가 아닙니다. 로봇이 기술을 습득하는 방식의 근본적인 전환점인 셈이죠.

어제의 데이터 굶주린 괴물

1X가 만들어낸 도약을 제대로 이해하려면, 먼저 기존의 방식을 알아야 합니다. Figure의 Helix부터 NVIDIA의 GR00T에 이르기까지, 대부분의 현대 로봇 공학 기반 모델은 VLA입니다. 이 모델들은 강력하지만, 고품질의 로봇 전용 시연 데이터에 대한 갈증이 끝이 없습니다. 이는 사람들이 수천 시간 동안 로봇을 원격 조종하며 컵을 집거나 수건을 접는 것과 같은 작업의 예시 데이터를 수집해야 한다는 의미입니다.

이러한 접근 방식은 진정으로 범용적인 로봇을 만드는 데 있어 커다란 장애물입니다. 비용이 많이 들고, 확장성이 떨어지며, 결과적으로 만들어진 모델은 취약하여 이전에 본 적 없는 객체나 환경에 직면하면 맥없이 무너질 수 있습니다. 마치 아이에게 모든 요리 프로그램을 마음껏 보게 하는 대신, 당신의 부엌에서 당신이 요리하는 모습만 보게 하며 요리를 가르치려는 것과 같습니다.

작은 꿈을 꿔봐… 집안일 하는 꿈을

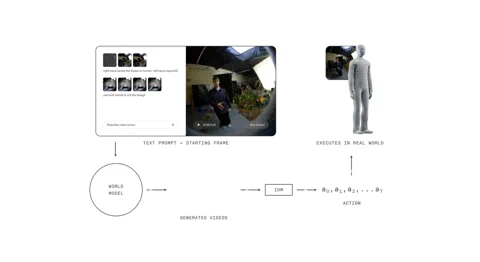

**1X 월드 모델(1XWM)**은 그런 구식 교범을 창밖으로 던져버립니다. 언어를 행동에 직접 매핑하는 대신, 텍스트 조건부 비디오 생성을 사용하여 무엇을 해야 할지 파악합니다. 이는 로봇이 행동하기 전에 효과적으로 미래를 ‘상상’할 수 있게 하는 두 부분으로 구성된 두뇌와 같습니다.

첫 번째는 시스템의 상상력 역할을 하는 140억 개의 매개변수를 가진 생성형 비디오 모델인 **월드 모델(WM)**입니다. NEO에게 “이 오렌지를 도시락에 싸라"와 같은 텍스트 프롬프트를 주면, WM은 현재 장면을 보고 그 작업이 완료되는 짧고 그럴듯한 비디오를 꿈꿉니다.

그다음, 기계 속의 현실주의자, **역동학 모델(IDM)**이 그 꿈을 분석합니다. 생성된 픽셀을 구체적인 모터 명령 시퀀스로 번역하여 시각적인 ‘무엇’과 물리적인 ‘어떻게’ 사이의 간극을 메웁니다. 이 과정은 다단계 훈련 전략을 통해 기반을 다집니다. 모델은 웹 규모의 비디오로 시작하여, 1인칭 시점을 얻기 위해 900시간의 인간 시점 비디오로 중간 훈련을 거치고, 마지막으로 NEO 자체의 몸에 적응하기 위해 단 70시간의 NEO 전용 데이터로 미세 조정됩니다.

훈련 파이프라인의 영리한 비법은 “캡션 업샘플링"입니다. 많은 비디오 데이터셋이 간결한 설명을 가지고 있기 때문에, 1X는 VLM을 사용하여 더 풍부하고 상세한 캡션을 생성합니다. 이는 더 명확한 조건을 제공하고 모델이 복잡한 지시를 따르는 능력을 향상시키는데, OpenAI의 DALL-E 3와 같은 이미지 모델에서도 유사한 이점을 보여준 기술입니다.

휴머노이드의 이점

이 비디오 우선 접근 방식 전체는 중요하고, 어쩌면 당연한 하드웨어 조각에 달려 있습니다. 바로 로봇이 사람과 같은 형태를 하고 있다는 점입니다. 수많은 시간 동안 인간이 세상과 상호작용하는 비디오로 훈련된 1XWM은 중력, 운동량, 마찰, 객체의 기능성 등 물리적 사전 지식에 대한 깊고 암묵적인 이해를 발전시켰습니다. 그리고 NEO의 몸이 근본적으로 인간과 유사한 방식으로 움직이기 때문에, 이 지식은 직접적으로 전이됩니다.

1X가 말했듯이, 하드웨어는 “AI 스택의 일등 시민"입니다. NEO와 인간 사이의 운동학적, 동역학적 유사성은 모델이 학습한 사전 지식이 일반적으로 유효하게 유지된다는 것을 의미합니다. 모델이 시각화할 수 있는 것은 NEO가 대부분 실제로 수행할 수 있습니다. 이러한 하드웨어와 소프트웨어의 긴밀한 통합은 시뮬레이션과 현실 사이의 종종 위험한 간극을 메워줍니다.

이론에서 현실로 (약간의 비틀거림과 함께)

결과는 설득력 있습니다. 1XWM은 NEO가 직접적인 훈련 데이터가 전혀 없는 작업과 객체에 대해서도 일반화할 수 있도록 합니다. 홍보 비디오는 로봇이 셔츠를 다리고, 식물에 물을 주고, 심지어 이전에 예시가 없던 작업인 변기 시트를 조작하는 모습을 보여줍니다. 이는 양손 협응 및 복잡한 객체 상호작용에 대한 지식이 인간 비디오 데이터로부터 성공적으로 전이되고 있음을 시사합니다.

하지만 이것이 마법은 아닙니다. 시스템에는 한계가 있습니다. 생성된 롤아웃은 성공에 대해 “지나치게 낙관적"일 수 있으며, 단안 사전 훈련은 약한 3D 기반을 초래하여, 생성된 비디오는 완벽해 보여도 실제 로봇이 목표물을 과소 또는 과대 조준하게 만들 수 있습니다. 시리얼 붓기나 스마일 그리기와 같은 능숙한 작업에서의 성공률은 여전히 난제로 남아 있습니다.

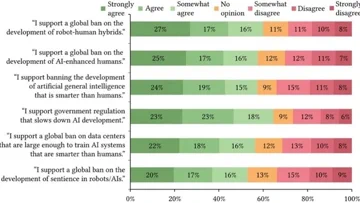

그러나 1X는 성능을 향상시킬 유망한 방법을 찾았습니다. 바로 ‘테스트 시간 컴퓨팅’입니다. “티슈 뽑기” 작업의 경우, 단일 비디오 생성 시 성공률은 30%였지만, 시스템이 8가지 가능한 미래를 생성하고 가장 좋은 것을 선택하도록 허용했을 때 45%로 껑충 뛰었습니다. 현재 이 선택은 수동으로 이루어지지만, VLM 평가기가 프로세스를 자동화하여 신뢰성을 크게 향상시킬 수 있는 미래를 가리킵니다.

스스로 학습하는 플라이휠

1XWM은 단순한 점진적 업데이트 그 이상을 의미합니다. 이는 데이터 병목 현상을 활짝 열어젖힐 잠재적인 패러다임 전환입니다. 이는 자기 개선을 위한 플라이휠을 만듭니다. 0이 아닌 성공률로 광범위한 작업을 시도할 수 있게 됨으로써, NEO는 이제 자체 데이터를 생성할 수 있습니다. 성공이든 실패든 모든 행동은 새로운 훈련 예시가 되어 모델에 다시 입력되어 정책을 정교하게 다듬을 수 있습니다. 로봇이 스스로를 가르치기 시작하는 것이죠.

물론, 주요 난관은 여전히 남아 있습니다. WM은 현재 5초짜리 계획을 생성하는 데 11초가 걸리고, IDM이 행동을 추출하는 데 1초가 더 걸립니다. 이 지연 시간은 역동적인 실제 환경에서는 영원과 같으며, 반응적인 작업이나 섬세하고 접촉이 많은 조작에는 시작조차 할 수 없는 수준입니다.

그럼에도 불구하고, 1X는 데이터 문제를 정면으로 다룸으로써, 로봇이 우리의 지루한 지시가 아닌, 우리의 집단적이고 기록된 경험으로부터 학습하는 미래의 문을 활짝 열었을지도 모릅니다. 그 미래는 인터넷 비디오 하나하나와 함께 가속화되고 있습니다.