NVIDIAが、自動運転の覇権争いに決定的な一石を投じた。2026年1月5日、同社が発表した「Alpamayo(アルパマヨ)」は、単なる画像認識モデルの域を遥かに超えている。それは、これまで自動運転車に決定的に欠けていた要素――「推論」し、自らの行動を「説明」する能力を授けるために設計された、広大なオープンエコシステムだ。Jensen Huang CEOは、これを「フィジカルAIにおけるChatGPT的瞬間の始まり」と称し、稀なケースや未知のシナリオに直面した際でも、車が自ら考え、最適解を導き出せる時代の到来を宣言した。

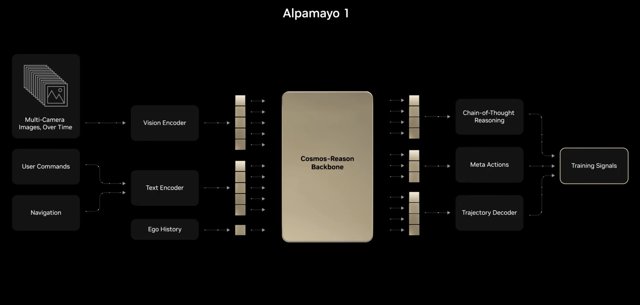

その中核を担う「Alpamayo 1」は、極めて強力な「視覚・言語・行動モデル(VLAM)」だ。噛み砕いて言えば、車が「見ているもの」を「言語ベースの理解」と結びつけ、次に「何をすべきか」を判断する仕組みである。特筆すべきは、このモデルが「明示的な推論トレース(Explicit Reasoning Traces)」を生成できる点だ。つまり、放置されたショッピングカートを避けるためにハンドルを切った際、AIがその「理由」を論理的に説明できるのである。この知能を鍛え上げるべく、NVIDIAは世界2,500以上の都市から収集した30万本を超える実走行クリップを収めた巨大なライブラリ「Physical AI dataset」も併せて公開した。

なぜ、これが「ゲームチェンジャー」なのか?

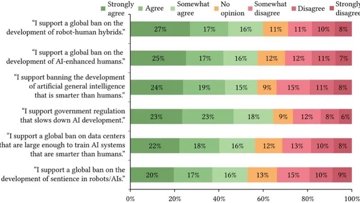

長年、自動運転業界は、中身の見えない「ブラックボックス」に対する世間の不信感という壁に突き当たってきた。判断プロセスが不透明なモデルでは、真の信頼を勝ち取ることはできない。NVIDIAは、意思決定のプロセスを言語化できる「説明可能なAI(XAI)」を推進することで、この信頼問題に正面から切り込んだ。

推論主導型のモデルへの移行は、停滞するレベル3の壁を突き破り、人間の介入を必要としない真のレベル4自動運転へと到達するための、極めて重要な——そしておそらく不可欠な——ピースとなるだろう。もはや車に求められているのは、単に道路を「見る」ことではない。そこにある状況を深く「理解」することなのだ。