ロボット業界に激震が走るような動きの中で、**北京人型ロボットイノベーションセンター(X-Humanoid)**が、同社のXR-1モデルを公式にオープンソース化した。これは、ただGitHubにポイと放り込まれた、ありふれたアルゴリズムとは一線を画す。XR-1は、中国の国家認定身体AI標準をクリアした初のVision-Language-Action(VLA)モデルであり、この標準は、ロボットを研究室の奇妙な展示物から、実用的な機械へと昇華させるための基準なのだ。今回のリリースには、XR-1モデル本体、包括的なRoboMIND 2.0データセット、そしてシミュレーション用の高精度デジタルアセットライブラリであるArtVIPが含まれている。

XR-1は、その核心において、ほとんどのロボットをぎこちなく、途方に暮れさせてきた「知覚と行動の壁」を粉砕するべく設計されている。開発者たちが「統合視覚・運動コード(UVMC)」と呼ぶ技術を採用し、ロボットが「見るもの」と「どのように動くべきか」の間に共通言語を作り出す。これにより、例えば、誰かがカップを動かせば、注ぐのをピタリと止める、といった、まるで「本能的」とも言える反応が可能になるのだ。3段階の訓練プロセスを経て、このモデルは、デュアルアームのFrankaシステムから、X-Humanoid独自のTien Kungシリーズ人型ロボットまで、まるで異なるロボットのボディにもスキルを適用できる汎用性を獲得した。

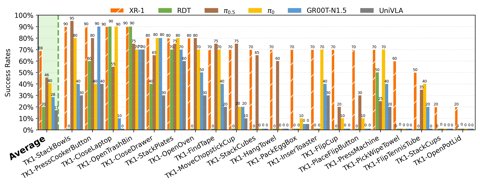

これは単なる机上の空論ではない。X-Humanoidは、XR-1が5種類の異なるドアを自律的に通り抜け、精密な産業用仕分けを実行し、さらにはCumminsの工場で重労働さえこなすことを実証している。この実力を裏付けるのが、現在30万以上のタスク軌跡を含むRoboMIND 2.0データセットと、ArtVIPのデジタルツインアセットだ。チームは、このシミュレーションデータを訓練に組み込むことで、現実世界でのタスク成功率を25%以上も向上させることができると、豪語している。

なぜこれがかくも重要なのだろうか?

モデルだけでなく、データとシミュレーションアセットからなるエコシステム全体をオープンソース化することで、X-Humanoidは実用的で自律的なロボットの開発を標準化するための、周到に練られた一手である。初の国家認定身体AIモデルを無償で公開することは、基盤となるプラットフォームを構築し、それによって参入障壁を下げ、分野全体を加速させる可能性を秘めている。これは、孤立した学術プロジェクトの枠を超え、ついに「仕事をやり遂げられる」ロボットを生み出すための共通の基盤を築くための戦略的な取り組みを示唆しているのだ。