مرز بعدی هوش مصنوعی: انتظارات از کنفرانس NVIDIA GTC 2025

چشمان دنیای فناوری به سن خوزه دوخته شده است، جایی که NVIDIA آماده میزبانی کنفرانس سالانه فناوری پردازنده گرافیکی (GTC) از ۱۷ تا ۲۱ مارس ۲۰۲۵ است. این رویداد که اغلب مهمترین گردهمایی نوآوری هوش مصنوعی محسوب میشود، امسال با اعلام پیشرفتهای بنیادینی همراه خواهد بود که میتواند چشمانداز فناوری را برای سال آینده دگرگون کند. با پیشبینی حضور ۲۵,۰۰۰ شرکتکننده حضوری و تقریباً ۳۰۰,۰۰۰ شرکتکننده مجازی، GTC 2025 به مثابه سیستم عصبی مرکزی پیشرفت هوش مصنوعی در طول هفته عمل خواهد کرد و میزبان بیش از ۱,۰۰۰ نشست با ۲,۰۰۰ سخنران و نزدیک به ۴۰۰ غرفهدار خواهد بود که فناوریهای نسل آینده را به نمایش میگذارند1.

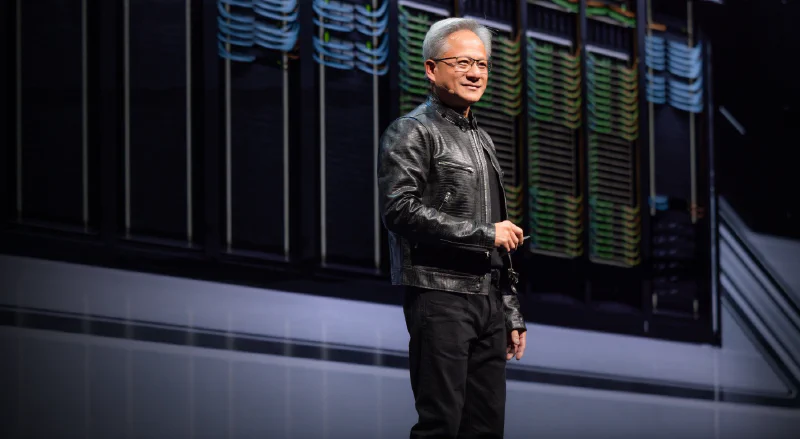

از آنجا که NVIDIA با سختافزارهایش پیشران بسیاری از تحولات هوش مصنوعی است، اعلامیههای این شرکت تأثیر قابل توجهی بر توسعهدهندگان، پژوهشگران و بازار گسترده دارد. سخنرانی اصلی جنسن هوانگ، مدیرعامل شرکت، که برای سهشنبه ۱۸ مارس برنامهریزی شده، لحن کنفرانس را تعیین خواهد کرد و احتمالاً نوآوریهایی را معرفی میکند که میتواند نسل بعدی قابلیتهای محاسباتی هوش مصنوعی را تعریف کند.

جاذبههای اصلی: چه چیزی در افق دید قرار دارد

معماری پردازنده گرافیکی نسل بعد

بدون شک، نورافکنها بر جدیدترین فناوریهای پردازنده گرافیکی NVIDIA خواهند تابید. کارشناسان صنعت انتظار دارند تمرکز ویژهای بر سری Blackwell B300، با نام رمز Blackwell Ultra باشد که هوانگ پیشتر تأیید کرده بود در نیمه دوم امسال عرضه خواهد شد. شایعه شده این تراشهها عملکرد محاسباتی بسیار بالاتری ارائه میدهند و مجهز به حافظه چشمگیر ۲۸۸ گیگابایتی هستند—ویژگی حیاتی برای آموزش و اجرای مدلهای هوش مصنوعی که به طور فزایندهای به حافظه بیشتری نیاز دارند2.

اما این همه ماجرا نیست—شرکتکنندگان باید آماده دریافت جزئیاتی درباره سری آینده پردازنده گرافیکی Rubin باشند که برای سال ۲۰۲۶ برنامهریزی شده و هوانگ آن را “یک پیشرفت بزرگ، بزرگ و عظیم” در قدرت محاسباتی توصیف کرده است. حتی زمزمههایی وجود دارد که سخنرانی اصلی ممکن است شامل نگاهی اجمالی به محصولات پس از Rubin باشد که احتمالاً نقشه راه بلندمدت NVIDIA برای پردازندههای گرافیکی را آشکار میکند.

هوش مصنوعی فیزیکی و رباتیک

انتظار میرود رباتیک جایگاه برجستهای در GTC امسال داشته باشد، زیرا مرزهای بین هوش مصنوعی مجازی و پیادهسازی فیزیکی همچنان محو میشوند. NVIDIA به طور پیوسته پلتفرم رباتیک خود را توسعه داده و GTC 2025 میتواند نشان دهد چگونه فناوریهای محاسباتی آنها سیستمهای خودمختار پیچیدهتری را در کاربردهای صنعتی، مصرفی و تخصصی امکانپذیر میکنند.

یکپارچهسازی هوش مصنوعی در سیستمهای فیزیکی یکی از هیجانانگیزترین مرزهای فناوری است که نشان میدهد چگونه شبکههای عصبی آموزشدیده در محیطهای مجازی میتوانند با دقتی بیسابقه به کاربردهای دنیای واقعی منتقل شوند.

هوش مصنوعی حاکمیتی: استقلال محاسباتی

با شکلگیری مجدد چشمانداز جهانی فناوری تحت تأثیر تنشهای ژئوپلیتیک، “هوش مصنوعی حاکمیتی” به نگرانی اصلی کشورها و شرکتهای بزرگ تبدیل شده است. این مفهوم—که بر توسعه قابلیتهای هوش مصنوعی متمرکز است که میتواند مستقل از زیرساختها یا دادههای خارجی در حوزههای قضایی خاص عمل کند—احتمالاً توجه قابل توجهی در GTC 2025 دریافت خواهد کرد.

رویکرد NVIDIA برای فعالسازی زیرساخت هوش مصنوعی حاکمیتی میتواند تعیین کند که چگونه کشورها اکوسیستمهای هوش مصنوعی خود را در یک محیط فناوری جهانی که به طور فزایندهای چندپاره شده، توسعه میدهند. انتظار میرود بحثهایی درباره پیکربندیهای سختافزاری تخصصی، مراکز داده محلی و چارچوبهایی که برای پاسخگویی به الزامات نظارتی متفاوت در مناطق مختلف طراحی شدهاند، مطرح شود.

انقلاب محاسبات لبه

غیرمتمرکزسازی هوش مصنوعی

یکی از مهمترین تغییرات در پیادهسازی هوش مصنوعی، حرکت به سمت محاسبات غیرمتمرکز است که قابلیتهای هوش مصنوعی را به جایی نزدیکتر میکند که دادهها تولید میشوند. این روند به ویژه برای کاربردهایی که نیازمند تصمیمگیری در زمان واقعی هستند، مانند خودروهای خودران، اتوماسیون صنعتی و زیرساختهای شهر هوشمند، مرتبط است.

ماژولهای Jetson شرکت NVIDIA، که فناوری پردازنده گرافیکی را در ماژولهای محاسباتی جاسازی شده ادغام میکنند، به فناوریهای اساسی برای توسعه هوش مصنوعی لبه تبدیل شدهاند. در GTC 2025، میتوانیم انتظار اعلام نسخههای جدید یا بهبودهای Jetson را داشته باشیم که قدرت محاسباتی بیشتری را در عین حفظ کارایی انرژی ارائه میدهند—تعادلی حیاتی برای استقرار در لبه.

محاسبات لبه مقاوم: سختافزار محاسباتی تخصصی طراحی شده برای عملکرد قابل اعتماد در محیطهای سخت که با دماهای شدید، ارتعاش، گرد و غبار، رطوبت یا شرایط برق ناپایدار مشخص میشوند. این سیستمها استقرار هوش مصنوعی را در محیطهای صنعتی، فضای باز و ماموریتهای حیاتی که سختافزار استاندارد در آنجا با شکست مواجه میشود، امکانپذیر میکنند.

محاسبات کوانتومی: پارادایم محاسباتی بعدی

روز کوانتوم در مرکز توجه

یک “روز کوانتوم” ویژه که برای ۲۰ مارس برنامهریزی شده، نشاندهنده علاقه روزافزون NVIDIA به فناوریهای محاسبات کوانتومی است3. در حالی که هوانگ به طور معروف در CES اعلام کرد که محاسبات کوانتومی واقعی همچنان “دههها” فاصله دارد، NVIDIA به وضوح ارزشی در موقعیتیابی خود در این حوزه نوظهور میبیند.

نشستها احتمالاً به بررسی چگونگی تکمیل رویکردهای کوانتومی توسط معماری محاسبات کلاسیک NVIDIA از طریق شبیهسازی و مدلهای ترکیبی که از نقاط قوت هر دو پارادایم بهره میبرند، میپردازند. ناظران صنعت باید توجه ویژهای به مشارکتهای بالقوه یا مجموعه ابزارهایی داشته باشند که محاسبات سنتی پردازنده گرافیکی را با ابتکارات تحقیقاتی کوانتومی پیوند میدهد.

زمینه صنعتی: چالشها و فرصتها

غلبه بر موانع فنی

مسیر به سوی هوش مصنوعی نسل بعد برای NVIDIA کاملاً هموار نبوده است. گزارشها نشان میدهد که کارتهای اولیه Blackwell از مشکلات شدید گرم شدن بیش از حد رنج میبردند که باعث شد برخی مشتریان سفارشات خود را کاهش دهند. چگونگی رفع این چالشها توسط NVIDIA—و اینکه آیا شرکت راهحلهای مؤثری را پیادهسازی کرده است—در طول ارائهها و نمایشهای GTC به دقت بررسی خواهد شد.

عبور از بادهای مخالف ژئوپلیتیک

کنترلهای صادراتی ایالات متحده و نگرانیهای تعرفهای تأثیر قابل توجهی بر عملکرد سهام NVIDIA در ماههای اخیر داشته و عدم قطعیت در بازار ایجاد کرده است. استراتژی شرکت برای عبور از این محدودیتها و حفظ رهبری بازار جهانی احتمالاً بر اعلامیههای مربوط به در دسترس بودن محصول، مشارکتهای تولیدی و استراتژیهای استقرار منطقهای تأثیر خواهد گذاشت.

رقابت از سوی مدلهای هوش مصنوعی کارآمد

ظهور آزمایشگاه هوش مصنوعی چینی DeepSeek، که مدلهای کارآمدی را توسعه داده که با مدلهای آزمایشگاههای پیشرو هوش مصنوعی رقابت میکنند، سؤالاتی را درباره تقاضای آینده برای پردازندههای گرافیکی پرقدرت NVIDIA مطرح کرده است. هوانگ مقابله کرده که چنین پیشرفتهایی در واقع به نفع NVIDIA هستند زیرا پذیرش گستردهتر هوش مصنوعی را تسریع میکنند، اما موقعیتیابی شرکت نسبت به این روندهای کارآمدی شایسته توجه است.

مدلهای استدلالی پرمصرف

با تکامل هوش مصنوعی به سمت قابلیتهای استدلالی پیچیدهتر، که با مدلهایی مانند o1 شرکت OpenAI نمایان شده، تقاضاهای محاسباتی همچنان در حال رشد است. به نظر میرسد NVIDIA آماده پذیرش این چالش است، با توجه به اینکه هوانگ این مدلهای پیشرفته را “کوه بعدی NVIDIA برای فتح کردن” معرفی کرده است. ارائههای GTC احتمالاً نشان خواهند داد که چگونه نقشه راه سختافزاری شرکت با این معماریهای نوظهور هوش مصنوعی همسو میشود.

آینده شکل میگیرد

GTC 2025 در لحظهای سرنوشتساز برای فناوری هوش مصنوعی فرا میرسد. موج اولیه هوش مصنوعی مولد نگاه ما را به قابلیتهای ماشینی متحول کرده است، اما کار سختتر جاسازی این فناوریها در سیستمهای فیزیکی، زیرساختهای حیاتی و تحقیقات علمی تازه آغاز شده است.

همانطور که NVIDIA به فشار آوردن به مرزهای آنچه از نظر محاسباتی ممکن است ادامه میدهد، GTC پنجرهای منحصر به فرد نه تنها به جهتگیری شرکت، بلکه به مسیر فناوری برای کل صنعت ارائه میدهد. چه توسعهدهنده باشید، چه پژوهشگر، سرمایهگذار یا علاقهمند به فناوری، اعلامیهها و بحثهای کنفرانس امسال درک شما را از مسیر بعدی هوش مصنوعی شکل خواهد داد.

برای کسانی که نمیتوانند شخصاً حضور یابند، NVIDIA سخنرانی اصلی هوانگ و بسیاری از نشستها را به صورت آنلاین پخش زنده خواهد کرد و این نگاه اجمالی به آینده را در سراسر جهان قابل دسترس میکند. شرکت حتی یک نمایش ویژه پیش از سخنرانی اصلی برنامهریزی کرده که توسط پادکست “Acquired” میزبانی میشود تا پیش از حضور هوانگ روی صحنه، شور و اشتیاق ایجاد کند.

در صنعتی که داستانهای علمی-تخیلی دیروز به طور منظم به فناوری معمول فردا تبدیل میشوند، GTC 2025 وعده میدهد که بار دیگر زمان لازم از تخیل تا اجرا را تسریع کند.

سؤالات متداول: NVIDIA GTC 2025

چه چیزی GTC 2025 را در مقایسه با سالهای گذشته به طور خاص مهم میکند؟

GTC 2025 در یک نقطه عطف حیاتی برای توسعه هوش مصنوعی برگزار میشود، زمانی که صنعت در حال گذار از موج اولیه هوش مصنوعی مولد به سمت کاربردهای پیچیدهتر در سیستمهای فیزیکی، مدلهای استدلالی و محاسبات علمی است. با چالشهای مربوط به عملکرد تراشه، محدودیتهای ژئوپلیتیک و رقبای نوظهور، اعلامیههای NVIDIA در این سال میتواند تأثیر قابل توجهی بر جهت توسعه هوش مصنوعی در میان یک چشمانداز به سرعت در حال تحول داشته باشد.

آیا اعلامیههای GTC 2025 عمدتاً به نفع پژوهشگران هوش مصنوعی خواهد بود یا تأثیرات گستردهتری خواهد داشت؟

در حالی که پژوهشگران قطعاً از پیشرفتها در معماری پردازنده گرافیکی و چارچوبهای هوش مصنوعی بهره خواهند برد، تمرکز GTC 2025 بر محاسبات لبه، هوش مصنوعی فیزیکی و راهحلهای حوزههای خاص، پیامدهای گستردهای در صنایع مختلف دارد. اعلامیهها احتمالاً بر توسعه خودرو، تولید، رباتیک، مراقبتهای بهداشتی و الکترونیک مصرفی تأثیر خواهند گذاشت و این کنفرانس امسال را برای مخاطبان بسیار گستردهتری نسبت به فقط جامعه پژوهشی مرتبط میکند.

چگونه ممکن است NVIDIA چالشهای کارآمدی مطرح شده توسط مدلهای نوظهور هوش مصنوعی را برطرف کند؟

NVIDIA احتمالاً یک رویکرد دو شاخه ارائه خواهد داد: ارائه قدرت محاسباتی خام بیشتر از طریق معماریهای نسل بعد مانند Blackwell Ultra و Rubin، در حالی که همزمان بهینهسازیهای نرمافزاری را معرفی میکند که کارایی را بهبود میبخشند. شرکت همچنین ممکن است پیکربندیهای تخصصی برای بارهای کاری مختلف هوش مصنوعی را برجسته کند و تصدیق کند که رویکرد یکسان برای همه در محاسبات هوش مصنوعی در حال تبدیل شدن به راهحلهای سفارشیتر برای کاربردهای خاص است.

سرمایهگذاران و ناظران صنعت باید به دنبال چه چیزی فراتر از اعلام محصولات پر زرق و برق باشند؟

فراتر از معرفی پردازنده گرافیکی جدید، به استراتژی NVIDIA برای عبور از کنترلهای صادراتی، مشارکت آن با ادغامکنندگان سیستم و ارائهدهندگان خدمات ابری، و چگونگی موقعیتیابی خود نسبت به تراشههای هوش مصنوعی تخصصی از رقبا توجه کنید. رویکرد شرکت به ابتکارات محاسبات کوانتومی، علیرغم احتیاط هوانگ درباره زمانبندی، ممکن است بینش ارزشمندی در مورد استراتژی متنوعسازی بلندمدت آن فراتر از توسعه سنتی پردازنده گرافیکی ارائه دهد.

اصطلاحات تخصصی

هوش مصنوعی حاکمیتی: توسعه فناوریها، زیرساختها و خطوط لوله داده هوش مصنوعی که میتوانند به طور مستقل در مرزهای ملی یا نظارتی خاص عمل کنند، کاهش وابستگی به فناوریها یا پلتفرمهای خارجی در حین حفظ کنترل بر دادههای حساس و منابع محاسباتی.

محاسبات لبه: یک پارادایم محاسباتی توزیع شده که محاسبات و ذخیرهسازی داده را به مکانی نزدیکتر میآورد که به آن نیاز است. برخلاف محاسبات ابری، که منابع را در مراکز داده دور متمرکز میکند، محاسبات لبه دادهها را به صورت محلی روی دستگاهها یا سرورهای نزدیک پردازش میکند، تأخیر و استفاده از پهنای باند را کاهش میدهد و قابلیت اطمینان و حریم خصوصی را بهبود میبخشد.

محاسبات موازی: نوعی محاسبه که در آن بسیاری از محاسبات یا فرآیندها به طور همزمان انجام میشوند. پردازندههای گرافیکی NVIDIA در این رویکرد برتری دارند و از هزاران هسته کوچکتر و کارآمدتر برای پردازش همزمان نقاط داده چندگانه استفاده میکنند—که آنها را برای بارهای کاری هوش مصنوعی که شامل مجموعه دادههای عظیم هستند، ایدهآل میکند.

محاسبات لبه مقاوم: سختافزار محاسباتی تخصصی طراحی شده برای عملکرد قابل اعتماد در محیطهای سخت که با دماهای شدید، ارتعاش، گرد و غبار، رطوبت یا شرایط برق ناپایدار مشخص میشوند. این سیستمها استقرار هوش مصنوعی را در محیطهای صنعتی، فضای باز و ماموریتهای حیاتی که سختافزار استاندارد در آنجا با شکست مواجه میشود، امکانپذیر میکنند.